这周AI圈有点热闹,英伟达股价跌了3.5%,Palantir跌了9.4%,Arm也跟着跌了5%。华尔街那边说,这波下跌可能跟MIT最新发布的一份报告有关。这份题为《生成式AI的鸿沟》的报告扔出了个重磅数据:尽管企业在生成式AI上砸了300到400亿美元,但95%的公司至今没看到任何商业回报。

作为天天跟代码和AI打交道的程序员,我看到这个数据第一反应是:这不就是我们公司去年那个AI项目的翻版吗?轰轰烈烈启动,半年后悄无声息,最后就剩下PPT里的"AI赋能"四个字。今天咱们就用MIT这份报告的数据,聊聊为什么这么多企业的AI项目都成了"烂尾工程"。

一、诡异的"AI悖论":80%的热闹,5%的实效

报告里有组数据特别有意思:超过80%的组织已经在探索或试点生成式AI,近40%说自己完成了部署。但真相是,这些所谓的"部署"大多是员工自己用用ChatGPT或Copilot,真正能给公司赚钱或省钱的企业级AI系统,只有5%真正落地了。

说白了,现在企业的AI应用就像KTV里的麦克风——谁都想拿起来唱两句,但真能上台演出的没几个。

行业差异大到离谱

不是所有行业都在AI浪潮里裸泳。MIT报告分析了8大行业,发现只有2个出现了显著的结构性变革。看下面这张图,Media & Telecom(媒体和电信)行业的颠覆性影响值是2,Professional Services(专业服务)是1.5,其他6个行业全是0.5。

我觉得这很符合实际观察。比如媒体行业,AI写稿、做视频已经很普遍了;但医疗、能源这些行业,AI还停留在"辅助分析"阶段,离真正改变业务流程还差得远。有个制造业的COO在访谈里说:“领英上都说一切都变了,我们实际运营里根本没变,就是合同处理快点而已。”

从试点到生产,是道悬崖

更扎心的是这个漏斗:通用AI工具(比如ChatGPT)从试点到落地的转化率看着还行,有83%;但企业定制化AI工具,60%组织评估过,20%进入试点,最后只有5%投入生产。这简直是从悬崖上跳下去啊!

为什么会这样?我自己用AI开发过项目,太有体会了。通用工具像瑞士军刀,啥都能干点但不精;企业定制化工具呢,往往是为了解决某个特定问题,但开发出来才发现,要么跟现有系统格格不入,要么用户觉得还不如自己手动干效率高。

二、钱都花哪去了?AI投资的"面子工程"

报告里有张AI投资分布图,我看完差点笑出声——70%的预算都砸到了销售和市场部门,后台运营这些真正能省钱的地方反而没人管。这就像家里装修,把钱全花在客厅的大吊灯上,卫生间漏雨却不管。

为啥会这样?很简单,销售和市场的成果看得见啊!"AI助力销售额提升X%"这种PPT多好看。后台运营的效率提升?对不起,老板看不到。有个药企的采购副总裁吐槽:“我买个工具帮团队提升效率,怎么量化?难道跟CEO说’我们科学家找资料快了点’?”

更有意思的是"影子AI经济"——90%的员工在用个人AI工具(ChatGPT、Claude这些)处理工作,但公司官方AI项目却停滞不前。我司设计师就是,用Midjourney做图比公司花20万买的正版工具还好使,最后大家都偷偷用个人账号。

三、试点项目为啥总"烂尾"?程序员视角的4个坑

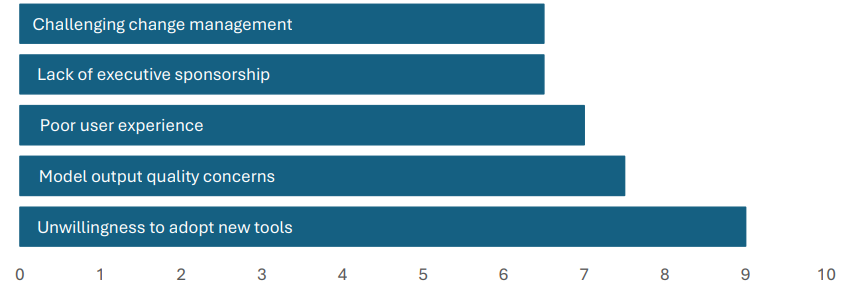

MIT报告采访了52家组织的高管和一线用户,让他们给AI试点失败的原因打分。结果有点出乎意料——排第一的不是技术问题,而是"变革管理挑战"(说白了就是大家不想用),排第二的是"AI系统无法学习和记忆"。

作为程序员,我太懂这个"无法学习和记忆"的痛了。去年我们给客服部门做智能问答系统,用的是某大厂的API。结果客服小姐姐天天吐槽:"同一个客户问同样的问题,系统每次都给不同答案,还记不住客户之前说过啥!"最后这系统就成了摆设。

报告里有个数据特别戳中我:日常用ChatGPT的员工,对企业内部AI工具的评价反而更低。为啥?因为大家已经被消费级AI惯坏了,觉得"AI就该这么好用",结果企业级工具又笨又不灵活。有个律师说得特别实在:“公司花5万美元买的合同分析工具,还不如我用ChatGPT自己调prompt来得准。”

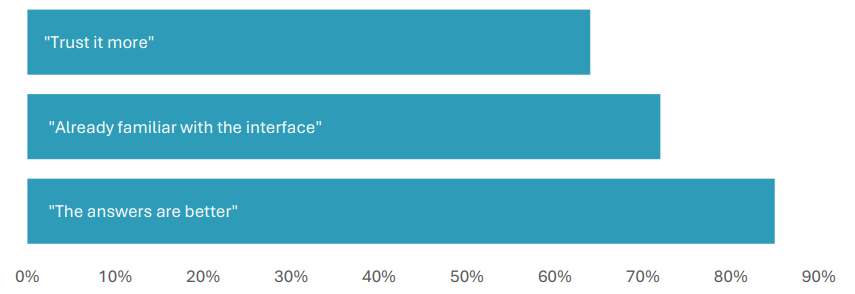

用户到底想要啥样的AI?报告里总结了三点:更信任(68%)、界面熟悉(65%)、答案质量更好(63%)。说白了,就是"别整那些花里胡哨的,好用、靠谱就行"。

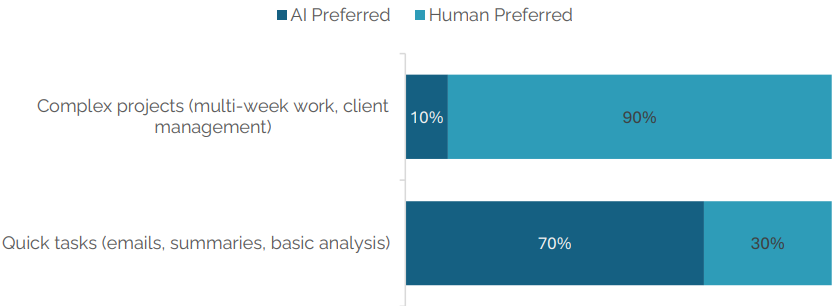

还有个现象挺有意思:AI在简单任务上已经能打败人类了——70%的人更愿意用AI起草邮件,65%用AI做基础分析。但遇到复杂任务,人类以9:1的优势碾压AI。这说明啥?现在的AI还只能当个"实习生",复杂决策还得靠老司机。

四、那5%成功的企业做对了什么?

报告里最有价值的部分,就是分析了那些成功跨越"AI鸿沟"的企业。我总结了几个关键点,都是程序员和技术管理者能直接用的:

1. 别自己瞎折腾,找外部伙伴

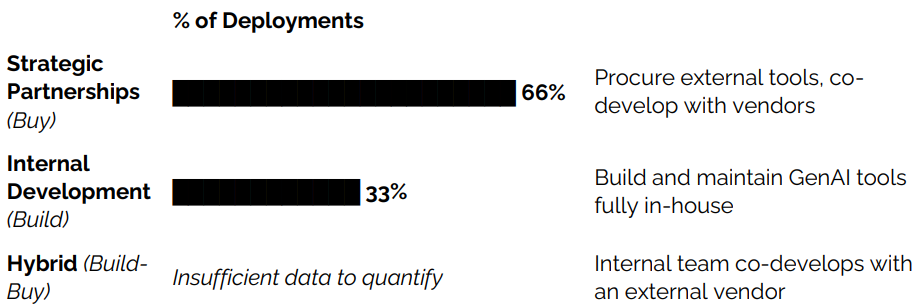

数据显示:借助外部合作伙伴的实施成功率比内部自行开发高出两倍(67% vs 33%)。我之前踩过坑,非要自己从零开发大模型应用,结果半年过去,开源社区已经有了更好的方案。说白了,现在AI技术迭代这么快,专业的事交给专业的人做,不丢人。

2. 从小处着手,别一上来就搞"大跃进"

成功的企业都是先在细分工作流里试错,比如客服通话总结、合同自动提取关键信息这种具体场景,看到效果了再扩展。有个初创公司就靠做销售线索分类,6个月就做到了120万年化收入。

3. 考核AI要看业务指标,不是技术参数

别再盯着"模型准确率99%“这种数字了,要看"成本降了多少”“客户满意度提升多少”。报告里有个案例,某企业用AI处理财务审批,虽然模型准确率"只有"85%,但处理速度提升了3倍,错误率下降60%,这就是成功。

4. 选供应商要看"学习能力"

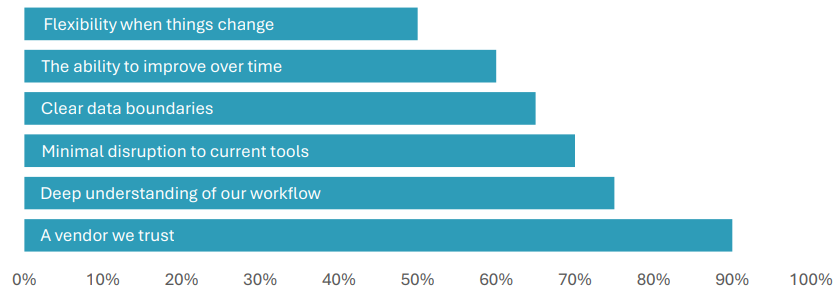

高管们选AI供应商时,最看重的三个能力:变化灵活性(72%)、随时间改进能力(68%)、数据边界清晰(65%)。说白了,就是要选那种"越用越聪明"的系统,而不是买个"一次性"的工具。

五、给程序员和技术管理者的3条实在建议

看完这份报告,结合我自己的经验,给大家几个 actionable 的建议:

1. 先做"影子AI审计":看看公司里大家都在用哪些个人AI工具,这些工具解决了什么问题——这往往是最好的需求来源。别再关起门来想"AI能做什么",而是看看"大家已经在用AI做什么"。

2. 试点项目一定要"小、快、灵":预算控制在团队能自主决策的范围内(比如10万以内),3个月内必须看到明确的业务指标变化(别用"提升效率"这种模糊词,要用"处理时间减少X%")。

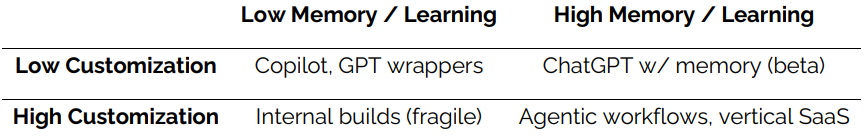

3. 别迷信"定制化":很多时候,用现成工具+少量开发(比如GPT+企业知识库)效果更好。报告里有个矩阵图很有意思,真正有价值的AI工具要么是高度定制化(比如针对特定工作流),要么是学习能力强(比如能记住上下文),中间状态的最容易失败。

最后说一句,生成式AI不是银弹,更像是个需要慢慢调教的助手。与其追求"高大上"的解决方案,不如先解决几个实实在在的小问题。毕竟,95%的失败案例告诉我们:AI项目,活下来比什么都重要。

(报告原文挺长的,有兴趣的可以自己找来看看,里面还有更多行业数据和案例。不过记得重点看数据部分,少看那些"展望未来"的空话——咱们程序员讲究的是落地,对吧?)