引言:逆向工程揭示AI编程助手的工程真相

近期,GitHub上一个名为shareAI-lab/analysis_claude_code的项目引发了技术社区的广泛关注。该项目对Anthropic公司的闭源产品Claude Code(v1.0.33)进行了深度逆向工程,成功还原了其95%的核心技术架构。这一突破不仅让我们首次得以窥见这款AI编程助手的内部工作机制,更为理解现代Agent系统的工程实现提供了宝贵的一手资料。

值得注意的是,项目README明确指出分析结果"非100%准确,分析过程中LLM难免出现幻觉,仅供学习参考",这提醒我们需以严谨态度对待这些逆向结论。本文将基于该项目公开的研究资料,对Claude Code的技术架构进行系统性解析。

逆向工程背景与方法论:以彼之矛攻彼之盾

Claude Code作为闭源产品,其核心逻辑被封装在约5万行经过混淆处理的JavaScript代码中。这些代码通过变量名替换、控制流打乱、字符串加密等手段隐藏了原始实现逻辑,构成了逆向工程的主要障碍。

shareAI-lab团队采用了一种颇具创意的"自举式"逆向方法:使用Claude Code本身分析其混淆后的代码。具体流程包括:将5万行混淆代码分割为15个chunk文件,利用Claude Code的代码理解能力进行初步解析,再通过人工调试和逻辑补全,最终拼接出系统架构全景。这种"用AI逆向AI"的方法,在处理大规模混淆代码时展现出独特优势。

Claude Code系统架构全景:五层分布式Agent操作系统

逆向分析揭示,Claude Code并非简单的代码补全工具,而是一套具备完整调度机制的"本地分布式Agent操作系统"。其架构可分为清晰的五层结构:

1. 用户交互层:多入口统一编码

最上层是用户交互接口,包括CLI命令行、VSCode插件和Web界面等多种形式。尽管入口不同,所有用户指令最终都会被编码为统一的请求格式,传递给下层的Agent核心调度系统。这一层的核心作用是屏蔽交互差异,标准化输入输出,确保不同入口的用户体验一致。

2. Agent核心调度层:nO主循环引擎的决策中枢

中间层是整个系统的"大脑"——Agent核心调度层。其核心组件是名为nO的主循环引擎(AgentLoop),负责协调所有智能体行为。根据逆向得到的流程图,nO引擎的工作流程包括:

- 消息预处理与任务识别

- 上下文状态评估与压缩判断

- 工具需求分析与Agent选择

- 并发任务调度与资源分配

- 执行结果整合与流式反馈

值得注意的是,大语言模型(LLM)在这一层仅作为被调度的工具存在,而非系统核心。nO引擎通过h2A消息队列(异步传输)和wu会话流生成器(实时输出)实现高效的任务流转,同时由wU2压缩引擎动态优化上下文数据。

3. 工具执行与管理层:精细化的Agent管控体系

工具执行层体现了Claude Code的"中台"特性,负责具体任务的分发与执行。核心管控组件包括:

- MH1工具引擎:负责工具发现、参数校验和任务分配

- UH1并发调度器:限制并发量,防止资源争抢和冲突

- SubAgent管理器:为每个子任务创建独立Agent实例,实现任务隔离

- 权限验证网关:基于最小权限原则,控制Agent对文件系统、网络等资源的访问

这种设计确保了任务执行的安全性、可审计性和故障隔离,即使某个子Agent出错,也不会影响整个系统的稳定性。

4. 工具生态系统:模块化的功能武器库

Claude Code的工具生态包含上百个分类明确的功能模块,覆盖文件操作、命令执行、网络搜索、任务管理等多个领域。与传统插件系统不同,这些工具采用文件级别的结构化配置,每个工具都是可管理、可审计、可热加载的独立单元。

工具定义采用.yaml格式,用户可通过添加自定义.yaml文件扩展功能,系统能自动发现并加载新工具,体现了良好的可扩展性设计。

5. 存储与持久化系统:分层记忆架构

存储层是Claude Code"记忆力"的基础,采用三层记忆架构:

- 当前会话(Messages):存储即时交互数据,支持实时对话

- 中期摘要(Compressed):由wU2压缩器处理的上下文摘要,平衡记忆深度与资源消耗

- 永久偏好(CLAUDE.md):记录用户语言偏好、项目结构、常用工具等长期信息

- 系统状态(StateCache):保存工具调用历史、错误记录、权限状态等系统元数据

这种分层设计使Claude Code在本地环境下就能构建出"类人记忆"的思维体系,无需依赖云端存储即可维持长时间交互的上下文连贯性。

核心技术创新:从功能实现到工程突破

逆向分析揭示,Claude Code的真正价值不在于支持多少功能,而在于其工程化实现的深度。其中两个技术创新尤为突出:

实时Steering技术:从"触发式"到"引导式"的交互升级

大多数AI工具采用"请求-响应"的触发式交互,用户需等待当前任务完成才能输入新指令。Claude Code则通过h2A消息队列实现了真正的"实时引导"(Steering)能力。其核心是"双缓冲队列+条件触发消费"机制:

class h2AAsyncMessageQueue {

enqueue(message) {

// 策略1: 零延迟路径 - 直接传递给等待的读取者

if (this.readResolve) {

this.readResolve({ done: false, value: message });

this.readResolve = null;

return;

}

// 策略2: 缓冲路径 - 存储到循环缓冲区

this.primaryBuffer.push(message);

this.processBackpressure();

}

}

这一设计实现了输入-处理-输出的流水线并行:当用户输入新指令时,系统无需等待当前输出完成即可开始处理新请求,配合流式写回机制,实现了"边生成、边调整、边响应"的实时交互体验。用户可在任务执行过程中随时"改变方向",系统能立即响应,大幅提升了交互效率。

智能上下文压缩:基于重要性的动态记忆管理

面对上下文长度限制这一普遍挑战,Claude Code的wU2压缩系统采用了"重要性加权+策略性摘要"的创新方案。其触发逻辑如下:

// 压缩触发逻辑

if (tokenUsage > CONTEXT_THRESHOLD * 0.92) {

const compressedContext = await wU2Compressor.compress({

messages: currentContext,

preserveRatio: 0.3,

importanceScoring: true

});

}

当token用量达到阈值的92%时,系统启动压缩流程,仅保留30%的关键内容,其余部分提炼为摘要。关键差异在于:压缩不以时间或长度为标准,而是通过重要性打分算法,优先保留对当前任务有价值的信息。这使得Claude Code在长时间交互中能维持"记忆重点",减少因上下文截断导致的"断片"问题。

逆向启示:AI编程助手的发展方向

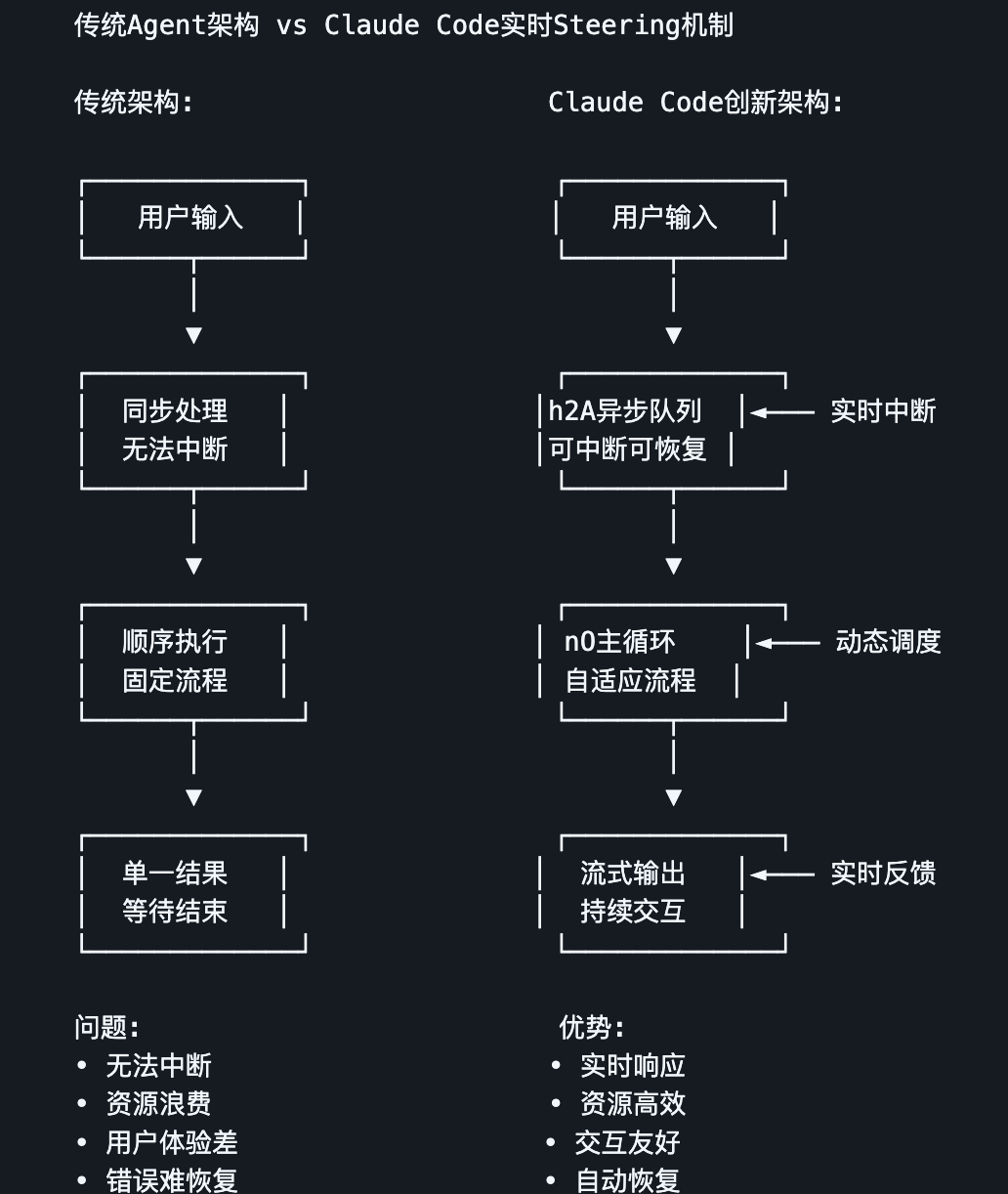

通过对比传统Agent架构与Claude Code的设计,我们可以清晰看到AI编程助手的进化路径:

传统架构往往追求"大而全"的功能集合,而Claude Code展示的是工程稳定性、安全性和组织能力的系统级突破。它证明未来的AI编程助手不会是简单的功能叠加,而将发展为具备以下特征的智能操作平台:

- 分布式Agent协作:通过精细的Agent调度和隔离机制,实现复杂任务的并行处理

- 动态资源管理:基于上下文重要性和系统状态,智能分配计算资源

- 安全可控执行:最小权限原则和严格的权限验证,确保操作安全性

- 本地优先设计:通过高效的本地存储和压缩算法,减少对云端的依赖

值得强调的是,shareAI-lab团队的逆向工程成果(仓库地址:https://github.com/shareAI-lab/analysis_claude_code,目前处于归档状态)为AI工程领域提供了宝贵的研究素材,让我们得以一窥闭源系统的设计思路。

结论:工程厚度决定产品高度

Claude Code的逆向分析揭示了一个关键事实:AI产品的竞争力越来越取决于工程实现的深度,而非单纯的算法创新。Anthropic通过精巧的Agent调度机制、实时交互优化和上下文管理策略,将大语言模型的能力系统化、工程化,打造出真正可用的AI编程助手。

这一案例也为AI领域的发展提供了启示:未来的技术竞争将更多聚焦于系统架构设计、资源优化和用户体验的工程实现,而非单一模型的性能指标。对于开发者而言,理解这种工程化思维,比追逐最新模型更为重要。

正如逆向文档中所暗示的,Claude Code展示的可能只是AI编程助手进化的开始。随着Agent技术的不断成熟,我们有理由期待更智能、更高效、更安全的AI开发工具的出现。